Reklame

Efter forsøger til elsker Bing Hvordan Bing forudsiger er blevet så godTid til at afslutte dit dagjob og begynde at spille via Bing-forudsigelser? Ikke helt, men lad os se på, hvordan Bing er blevet så god til at forudsige fremtiden. Læs mere , flirter med det forbedrede privatliv DuckDuckGo 10 nyttige DuckDuckGo øjeblikkelige svar, der sparer dig tid og et par klikInstant Answers er en samling af DuckDuckGo-godbidder, der potentielt gør dit online søgningsliv noget lettere. Her er ti fra en enorm liste, som du kan prøve på denne alternative søgemaskine. Læs mere , og (lukker) endda forsøger at se, om Yahoo var bedre end sidste gang jeg brugte det (ca. 2004), kan jeg stadig ikke finde en bedre mulighed for online-søgning end den regerende mester, Google.

Gabet er ved at indsnævre, men i sidste ende er Google stadig konge på grund af resultaternes relevans, hastighed, hvorpå websteder indekseres og søgninger udføres, og deres konstante skub for at blive jævn bedre.

Efter et halvt dusin (eller flere) mislykkede forsøg i årenes løb på at finde

et bedre alternativ 13 alternative søgemaskiner, der finder, hvad Google ikke kanGoogle-søgning kan stadig ikke gøre alt. Disse 13 alternative søgemaskiner kan tage sig af et par nichearbejde for dig. Læs mere , førte det mig til at forsøge at dechiffrere, hvad der gør Google bedre end konkurrenter i dette rum.Her er hvad jeg fandt.

En kort historie med søgemaskinteknologi

Først føler jeg, at det sandsynligvis er klogt at se på noget af den teknologi, der driver søgemaskiner Hvordan fungerer søgemaskiner?For mange mennesker er Google internettet. Det er uden tvivl den vigtigste opfindelse siden selve Internettet. Og selvom søgemaskinerne har ændret sig meget siden, er de underliggende principper stadig de samme. Læs mere , og de virksomheder, der fik os her.

Skabelsen af Archie (1990)

Archie anses vidt for at være den første søgemaskine. Skønt tilsyneladende primitiv nu, var Archie et værktøj, der indekserede offentligt tilgængelige FTP-websteder i et forsøg på at give brugerne mulighed for at finde specifikke filer. Dette var for hele verden, så du skulle have adgang til Archie-serverne ved hjælp af en lokal klient eller gennem Telnet Hvad er Telnet og hvad er dens anvendelser? [MakeUseOf Explains]Telnet er et af de tekniske termer, som du lejlighedsvist kan høre, men ikke i en annonce eller en liste over vaskerier over ethvert produkt, du måtte købe. Det er fordi det er en protokol eller et sprog ... Læs mere , som er en netværksprotokol, der giver mulighed for tilslutning af to computere på det samme netværk.

Archie ansporede til innovation inden for yderligere teknologier, der fungerede på lignende måde, såsom Veronica og Jughead, VLib, Gopher og andre. Disse teknologier var pionererne inden for søgebranchen, selvom de hurtigt blev erstattet af mere avancerede teknologier.

World Wide Web Wanderer (1993)

Oprettet i 1993 var World Wide Web Wanderer den første bot oprettet til at indeksere websteder og automatisk indsætte dem i en database. Wandex startede som det blev som en måde at måle størrelsen på nettet ved at tælle aktive servere over hele verden for at måle vækst. I stedet blev det planen for moderne web-edderkopper, der er ansvarlige for at gennemgå internettet for at indeksere dens indhold.

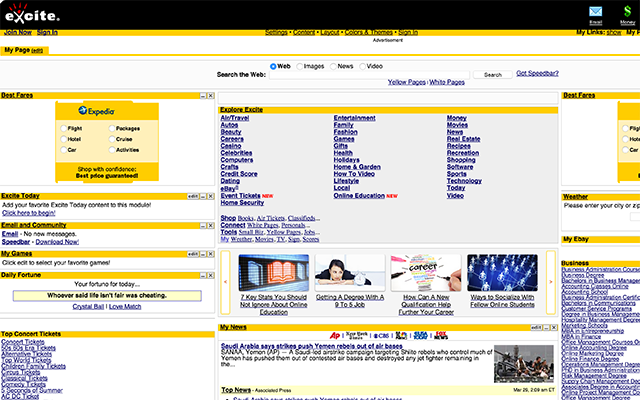

Excite (1993)

Excite var et projekt af seks studerende ved Stanford University, der forsøgte at bruge statistisk analyse af sammenhænge på fælles sprog for at forbedre relevansen i indeksering. Excite - derefter kendt som Architext - brugte journalister til at skrive korte webstedsanmeldelser for forbedret brugervenlighed sammenlignet med mere primitive linkbaserede søgemaskiner og mapper.

Search Engine Boom (1994)

1994 var sandsynligvis det største enkeltår i søgemaskinernes historie. Inden for en 12-måneders periode så vi lanceringen af Infoseek, AltaVista, WebCrawler, Yahoo! og Lycos.

- Infoseek: Tilladte brugere at indsende deres websider i realtid og indekserede dem automatisk baseret på brugerdefinerede kategorier.

- AltaVista: Den første søgemaskine, der bruger ubegrænset båndbredde, tillader søgeforespørgsler efter naturligt sprog og brugen af søgemodifikatorer for at godkende resultater.

- WebCrawler: Den første crawler, der indekserede hele sider i modsætning til bare titler eller titler og beskrivelser.

- Lycos: Den første søgemaskine til at sortere efter relevans. Lycos havde også konsekvent den største database over gemte websteder, og på sit højdepunkt (ca. 1996) var tjenesten gennemsøgt og indekseret over 60 millioner websteder.

Søgemaskiner i løbet af denne periode (og flere år senere) brugte kraftigt metatags, der indeholdt titel, beskrivelse og nøgleordselementer føjet til et websted af webmasteren. Disse tags såvel som søgeordstætheden inden for teksten på et websted var de primære rangeringsfaktorer, som hjalp edderkopper med korrekt identificering og indeksering af indhold.

Det åbnede også døren til webspam, da tidlige SEO-eksperter hurtigt lærte at manipulere dette system ved at fylde nøgleord i tags og indhold på en unaturlig måde i et forsøg på at spille systemet.

Ask / Ask Jeeves (1997)

Ask - og deres Ask Jeeves-service - brugte menneskelige redaktører til at forsøge at liste populære brugersøgespørgsmål til lister over både partner- og betalte inkluderingswebsteder. Tjenesten brugte automatisering i form af et rangeringssystem kaldet DirectHit, som forsøgte at rangere sider efter popularitet, men de fandt, at dette var for let at manipulere og ophørte med at bruge motoren et par år senere.

MSN / Bing (1998/2009)

MSN lancerede deres egen søgemaskine til piggyback på succes fra andre Microsoft-produkter og overgår til online-søgning. Søgemaskinen var afhængig af Overture, Looksmart og andre betalte inkluderingsmapper for at give søgeresultater, indtil Google beviste succesen med deres backlink-model.

Dette konceptbevis fra Google førte til, at MSN vedtog en lignende strategi - selvom den ikke var så god - i 2004.

I 2009 omdirigerede MSN som Bing og forbedrede brugergrænsefladen til at inkludere inline search (forslag, der vises, mens du skriver), indhold, der vises på søgeresultatside (i modsætning til at skulle klikke på et link til et af søgeresultaterne) og en række nye funktioner designet til at gøre søgningen lettere og mere tilgængelig.

Hvordan Google blev bedst (og hvorfor det stadig er)

I slutningen af 90'erne var søgemaskiner blevet næsten ubrugelige på grund af relevansen (eller manglen derpå) på søgeresultater og udbredelsen af web-spam. Før lanceringen i 1998, og i et halvt årti efter, havde konkurrenterne virkelig ikke noget svar på monteringsspørgsmålene forårsaget af webspam og manipulation af søgemaskiner - som i sidste ende blev kendt som SEO (søgemaskine) optimering).

Gå ind på Google.

Google startede som et projekt - kendt som BackRub - af Larry Page og Sergey Brin i 1996. Formålet med dette projekt var at revolutionere søgningen ved hjælp af links som den primære rangmåling for at forbedre relevansen. Teorien - kendt som citation notation - drejede sig om ideen om, at hvert websted, der linkede til et andet sted, i det væsentlige udtrykte deres tillid til det indhold, der blev tilbudt på dets sider. Disse links tjente som stemmer, og ankerteksten inden for linket fungerede som en måde at indeksere websteder på, baseret på hvad andre udstedte disse stemmer for.

Teknologien var spændende, og det førte til, at Brin og Page forsøgte at sælge den til konkurrenter i søgeverdenen for en rapporteret $ 750.000. Heldigvis var ingen interesseret. Tilbage til tegnebrættet fortsatte Page og Brin med at forbedre teknologien, og i 2000 var Google den største søgemaskine i verden.

Sådan holder Google sig på toppen

Tilpasningsevne er muligvis den bedste måde at beskrive, hvordan Google forbliver den mest anvendte søgemaskine i verden. Når marketingfolk og søgemaskinspecialister lærer at manipulere systemet, ændrer Google det. Når nye teknologier - såsom sociale medier - begynder at spille en aktiv rolle i vores samtaler, finder Google en måde at integrere dem i algoritmen for at forbedre relevansen. Når søvaner ændres, ændrer Google sig med dem.

Google ser konstant, analyserer og udvikler sig. Ved at bruge de enorme mængder data, de indsamler fra hver af os ved hjælp af deres produkter, er de det i stand til konstant at levere et bedre, mere relevant og brugervenligt produkt end noget andet konkurrenter.

Sådan ser søgningens fremtid ud

Mens Google er på toppen, og der ikke ser ud til at være nogen konkurrenter i horisonten, der er i stand til at fjerne dem, ændrer ting sig hurtigt på nettet. Dette er, hvad Google - og andre - gør for at forbedre relevansen af vores søgeresultater både nu og i den nærmeste fremtid.

Forståelse af brugerintentiv og semantik

Søgemaskiner - inklusive Google - bruges til at levere resultater baseret på, hvor godt forespørgsler matchede med websider. Nu, Bing, Google og Yahoo! alle forsøger at forbedre deres resultater baseret på at forstå hensigten bag dem, kendt som semantisk søgning Hvad semantisk markup er & hvordan det vil ændre Internettet for evigt [Teknologi forklaret] Læs mere .

Hvis en bruger f.eks. Søger efter “Bedste fisk”, ville resultaterne i de forgangne år afhænge af hvilket websted, der blev betragtet som det mest autoritative for disse søgeord. Nu lægger søgemaskiner en større vægt på at forstå, hvad du leder efter specifikt, så de kan levere de mest optimerede resultater. I dette tilfælde er brugeren sandsynligvis på udkig efter de bedste fiskerestauranter i nærheden eller opskrifter. At forstå, at der på tværs af billioner af mulige søgeforespørgsler er, hvor tingene bliver komplicerede.

Større vægt på placering

Ovenstående eksempel på en forespørgsel om skaldyr er en af de primære årsager til, at placering bliver så vigtig. Du leder sandsynligvis ikke efter skaldyrsrestauranter i San Francisco, hvis du bor i Singapore (men hvis du er det, skal du bare tilføje "i San Francisco" til din forespørgsel). Placeringsbaseret søgning ændrer alt, da alle større søgemaskiner nu bruger din placering for at levere tilpassede resultater til dine søgninger.

Forbedret mobiloplevelse

2015 var første gang i historien, at mobiltrafik overskredet laptops og desktops, og det er stadig en tendens med hurtig opadgående bevægelse. Faktisk er den fleste webtrafik, der stammer fra smartphones, søgerelateret. På grund af den skiftende tid, vi lever i, er det vigtigt at levere en poleret mobiloplevelse til mobilbrugere.

Google gør netop dette ved at frigive en ny mobil algoritme, der skjuler websteder, der ikke vises korrekt på mobile enheder. Denne algoritmiske ændring er kun til mobiltrafik, men den skal berige oplevelsen for mobilbrugere og føre vejen for yderligere mobilinnovation.

Yahoo! er en anden vigtig søgemaskine med fokus på mobil. CEO Marissa Mayer (en tidligere Google-medarbejder) har skiftet fokus for Yahoo! for at prioritere mobil som et primært middel til at genvinde relevansen.

Viden graf

Bing og Google er begge i vid udstrækning investeret i at bruge deres massive databaser med information for at give hurtige bitt af information til specifikke nøgleord og sætninger. For at forbedre brugeroplevelsen forsøger begge at fjerne yderligere trin, som brugeren skal tage for at finde information og i stedet stole på viden graf teknologi Et dybdegående kig på Googles nye viden graf Læs mere .

F.eks. Indeholder film, berømthedsnavne eller lokaliseringsrelaterede forespørgsler nu oplysninger om forespørgslen øverst på siden. Ved hurtige søgninger kan dette muligvis spare dig for de yderligere trin for at skulle grave dybere gennem resultaterne eller besøge flere steder for at finde informationen.

Dette har store konsekvenser på mobilen såvel som stemmesøgning (som Siri eller Google Now), da de fleste søgninger er hurtige forsøg på at hente infromation i modsætning til udtømmende søgninger efter forskning.

Find nye måder at forbedre algoritmer på

Søgemaskiner er konstant i krig med hinanden såvel som de ukendte, der lurer lige rundt om hjørnet. I et forsøg på at være bedst skal hver levere meget relevante resultater og hurtigt. Som sådan ændres algoritmer på alle større søgemaskiner konstant i et forsøg på at holde sig foran kurven og finde nye målinger, der kan føre til bedre resultater.

Et af de mest spændende eksempler på dette kan være Videnbaseret tillidsscore Kan Google bruge en algoritme til at bestemme sandheden?Google undersøger, om dens algoritme kan omfatte sandhed som en placeringsfaktor. Hvad betyder det for nettet? Læs mere , baseret på et patent indeholdt af Google. Mens Google direkte har nægtet enhver hensigt om at bruge dette patent i deres søgealgoritme i den nærmeste fremtid, er implikationerne af det enorme. Hvis du nogensinde har fået dårlige oplysninger efter en online søgning, kan dette nye scoringssystem ændre alt dette efter placering af websteder baseret på resultater i Googles Knowledge Vault (faktabutikker trukket fra indekseret indhold), og hvor godt de er matche.

I sidste ende er det en suveræn øvelse i futilitet at prøve at forudsige, hvordan søgemaskinteknologi uden for det næste år eller to ser ud. Når det er sagt, skal det fortsætte med at få os et skridt nærmere en alder, hvor vi er mødt med svaret på ethvert spørgsmål på en nærmest øjeblikkelig måde.

Er der en bedre søgemaskine end Google? Hvad gør det bedre? Hvilke søgerelaterede teknologier eller ændringer er du mest glade for at se i den nærmeste fremtid? Lyd fra i kommentarerne nedenfor. Jeg ville elske at høre dit tag!

Billedkredit: Søgemaskine via Shutterstock, Firefox Mobil af Johan Larsson via Flickr, Websteds kodeoptimering via Shutterstock

Bryan er en USA-født udstationerede, der for tiden bor på den solrige Baja-halvø i Mexico. Han nyder videnskab, tech, gadgets og citerer film fra Will Ferrel.